Los investigadores afirman que los pequeños modelos de lenguaje están de moda.

Los modelos más grandes son capaces de realizar una mayor diversidad de tareas, sin embargo, el tamaño compacto de los modelos más pequeños los convierte en herramientas muy atractivas.

Los modelos de lenguaje de gran tamaño son eficaces debido a su magnitud. Las últimas versiones desarrolladas por OpenAI, Meta y DeepSeek emplean cientos de miles de millones de "parámetros", que son los ajustes que regulan las conexiones entre datos y que se modifican durante el proceso de entrenamiento. A medida que aumenta el número de parámetros, los modelos mejoran su capacidad para identificar patrones y relaciones, lo que los hace más potentes y precisos.

Sin embargo, esta potencia conlleva un alto coste. Para entrenar su modelo Gemini 1.0 Ultra, Google invirtió aproximadamente 191 millones de dólares. Los modelos de lenguaje grande (LLMs) también requieren un considerable poder computacional cada vez que generan respuestas, lo que les ha ganado la reputación de ser grandes consumidores de energía. Según el Electric Power Research Institute, una sola consulta a ChatGPT consume alrededor de diez veces más energía que realizar una búsqueda en Google.

Como respuesta a esta situación, algunos investigadores han comenzado a buscar alternativas más pequeñas. Recientemente, IBM, Google, Microsoft y OpenAI han lanzado modelos de lenguaje pequeños (SLMs), que utilizan unos pocos miles de millones de parámetros, una fracción de lo que utilizan sus contrapartes más grandes. Aunque estos modelos no son apropiados como herramientas de propósito general, destacan en tareas específicas y definidas, como resumir conversaciones, contestar preguntas de pacientes en chatbots de salud y recopilar información en dispositivos inteligentes. Zico Kolter, científico informático de Carnegie Mellon University, comenta que "para muchas tareas, un modelo de 8 mil millones de parámetros es bastante eficaz". Además, estos modelos pueden ejecutarse en portátiles o teléfonos móviles, en lugar de necesitar un gran centro de datos (no hay un consenso claro sobre la definición exacta de "pequeño", pero los nuevos modelos suelen tener un máximo de alrededor de 10 mil millones de parámetros).

Para optimizar el proceso de entrenamiento de estos modelos reducidos, los investigadores utilizan diversas estrategias. Los modelos grandes suelen extraer datos de entrenamiento crudos de internet, que pueden estar desorganizados y ser difíciles de procesar. Sin embargo, estos modelos grandes pueden generar un conjunto de datos de alta calidad que sirve para entrenar un modelo pequeño. Este enfoque, conocido como destilación de conocimiento, permite que el modelo más grande transfiera efectivamente su aprendizaje, similar a un profesor enseñando a un alumno. Kolter señala que "la razón por la cual los SLMs son tan eficaces a pesar de tener pocos parámetros y pocos datos es que utilizan datos de alta calidad en lugar de los desordenados".

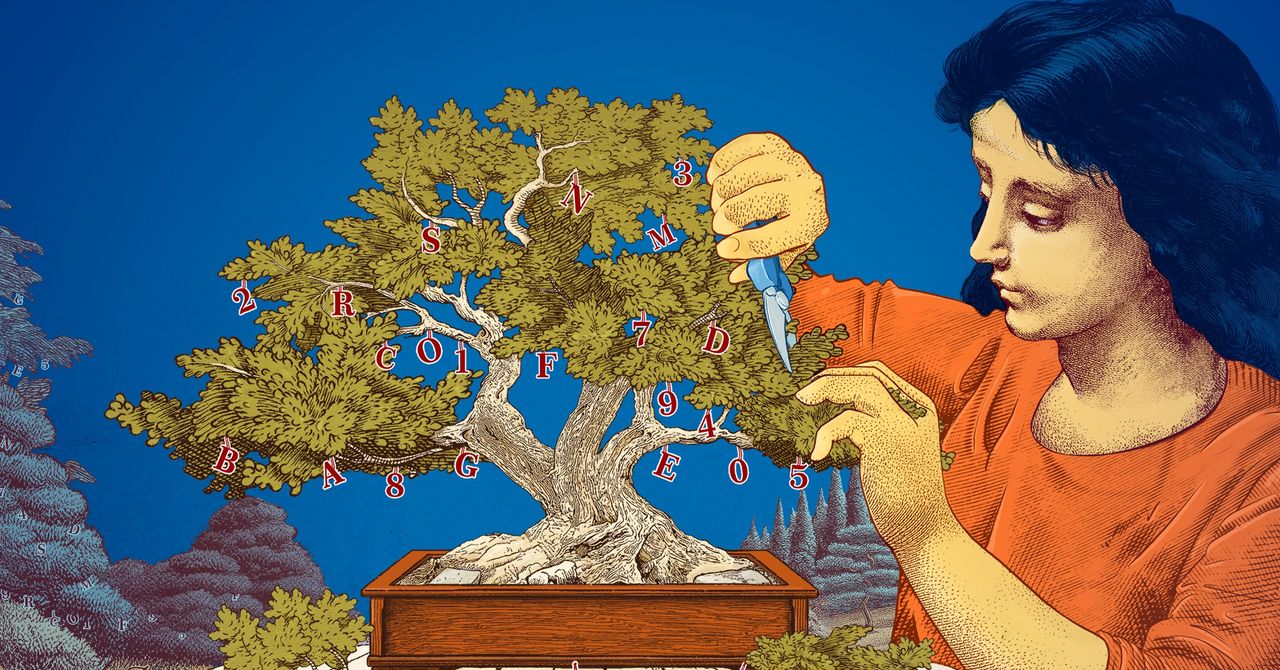

Los investigadores también han explorado métodos para crear modelos pequeños a partir de grandes, como el método de poda, que consiste en eliminar componentes innecesarios o ineficientes de una red neuronal. Esta técnica fue inspirada por el cerebro humano, que vuelve más eficiente al recortar conexiones entre sinapsis a medida que una persona envejece. Las técnicas de poda actuales se remontan a un artículo de 1989 del científico informático Yann LeCun, donde argumentaba que se podía eliminar hasta el 90% de los parámetros en una red neuronal entrenada sin perder eficiencia, denominando a este enfoque como "daño cerebral óptimo". La poda ayuda a los investigadores a ajustar un modelo de lenguaje pequeño para tareas o entornos específicos.

Para los científicos interesados en entender el funcionamiento de los modelos de lenguaje, los SLMs representan una opción económica para probar ideas innovadoras. Además, al tener menos parámetros que los grandes modelos, su razonamiento puede resultar más transparente. Leshem Choshen, investigador en el MIT-IBM Watson AI Lab, afirma que "si deseas crear un nuevo modelo, necesitas experimentar". Los modelos pequeños permiten a los investigadores probar diferentes enfoques con menores riesgos.

A pesar de que los grandes y costosos modelos seguirán siendo relevantes para aplicaciones como chatbots generalizados, generadores de imágenes y descubrimiento de fármacos, para muchos usuarios un modelo pequeño y centrado puede ser igual de efectivo, además de ser más fácil de entrenar y construir. Según Choshen, "estos modelos eficientes pueden ahorrar dinero, tiempo y recursos computacionales".