Cómo garantizar que los asistentes de inteligencia artificial sean colaboradores confiables en las instituciones financieras

Garantizar que los nuevos co-pilotos de inteligencia artificial sean compañeros de confianza.

La implementación de asistentes de inteligencia artificial (IA) está avanzando rápidamente en instituciones de servicios financieros, como bancos, gestores de activos y numerosas fintechs que se dedican al cumplimiento normativo. Este cambio representa una de las transformaciones más significativas en el ámbito laboral en las últimas décadas. Con la transición de pruebas de concepto a implementaciones a gran escala, es crucial que las empresas aseguren que estas herramientas aporten valor sin generar complicaciones adicionales.

Es aquí donde la importancia de los equipos integrados se vuelve evidente. En Synechron, los equipos están colaborando con miles de personas en el sector financiero para incorporar y trabajar con asistentes de IA. Este ajuste no es sencillo, ya que no se puede esperar que los empleados se adapten de inmediato a tales cambios. Se ha demostrado que la formación a nivel organizacional, dirigida por expertos en IA que están integrados con los equipos de negocio, es esencial para que los usuarios comprendan las capacidades y limitaciones de estas herramientas, manteniendo la seguridad.

También es vital que las empresas definan qué información se considera fiable. Un marco de seguridad integral debe ir más allá de simples advertencias en las búsquedas de asistentes de IA. Esto implica educar a los empleados sobre la diferencia entre conjuntos de datos internos seguros y fuentes abiertas en internet, así como instruirlos sobre la verificación de hechos para minimizar los riesgos de errores de interpretación del modelo, y ser conscientes de cuestiones éticas y regulatorias. En el caso de las instituciones financieras, es fundamental operar en entornos controlados, especialmente al manejar datos sensibles.

Desde el punto de vista de la seguridad y la privacidad, existen inquietudes válidas sobre el uso de herramientas de IA generativa en el trabajo. Al igual que ocurrió con la adopción de servicios en la nube, es necesario garantizar que los datos se mantengan seguros tanto en tránsito como en reposo. Las empresas deben tener claridad sobre la dirección de sus datos: si se están utilizando en un entorno de nube seguro o en un sistema público como ChatGPT. La falta de transparencia en cómo estos modelos de "caja negra" gestionan los datos es una gran preocupación para muchas organizaciones.

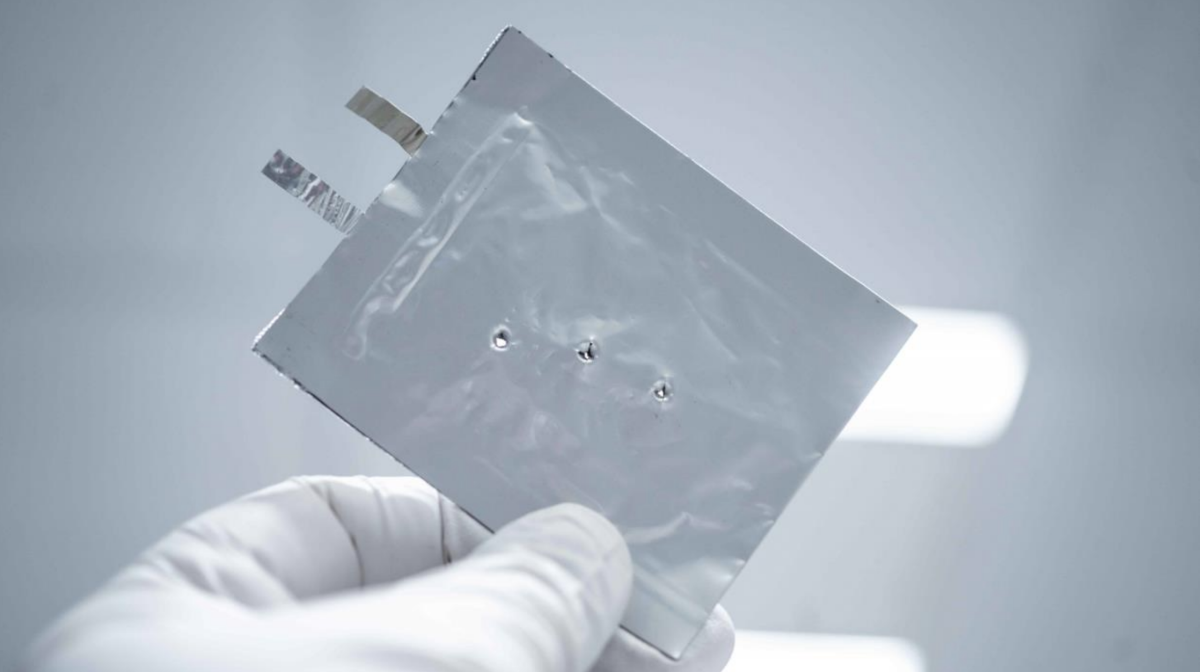

Algunos instrumentos no son adecuados para casos de uso empresarial que incluyan información sensible. ChatGPT, por ejemplo, está diseñado para el consumo público y puede no ofrecer las mismas garantías de seguridad que un sistema empresarial. A su vez, herramientas como GitHub Copilot generan código directamente en el entorno de desarrollo basado en las solicitudes del usuario, lo que podría introducir vulnerabilidades si el código se ejecuta sin revisión.

De cara al futuro, la integración de la IA en sistemas operativos y herramientas de productividad podría agravar estos desafíos. Una nueva característica de Microsoft, llamada Recall, captura capturas de pantalla de las actividades del usuario para crear una línea de tiempo buscable, lo que plantea preocupaciones sobre el posible abuso de vigilancia y el mal uso de datos por actores malintencionados. Los departamentos de cumplimiento deben evaluar y alinear las características de estas tecnologías con los requisitos regulatorios relacionados con la recolección y el reporte de datos.

A medida que las capacidades de IA se expanden y se vuelven más autónomas, existe el riesgo de delegar decisiones críticas que afectan la privacidad y los derechos de los usuarios a estos sistemas. Sin embargo, hay buenas noticias: proveedores de nube consolidados como Azure, AWS y GCP brindan entornos seguros e independientes para implementar modelos de IA que se integran de manera segura con la autenticación empresarial. Las empresas también tienen la opción de ejecutar modelos de lenguaje grande (LLMs) en sus propias instalaciones, detrás de sus cortafuegos, usando modelos de código abierto para entender mejor los datos utilizados en su entrenamiento.

La transparencia en los modelos de IA es crucial para fomentar la confianza y la adopción. Los usuarios merecen tener claridad sobre cómo se manejan y procesan sus datos, así como la opción de optar por participar o no. La privacidad debe ser un principio de diseño fundamental desde el inicio, y no una consideración posterior. Además, la gobernanza robusta de la IA, junto con una validación rigurosa de los modelos, es esencial para asegurar que estos sistemas sigan siendo seguros y efectivos ante la rápida evolución de la tecnología.

Finalmente, es importante que las organizaciones realicen revisiones de rendimiento, al igual que lo harían con cualquier empleado humano. Si un asistente de IA es considerado como un colega más, debe ser evidente que está aportando valor que justifique los costos de su formación y operación continua. Es fácil olvidar que simplemente "integrar IA" en una empresa no aporta valor por sí mismo.

Se cree que estas herramientas serán vitales y formarán parte de la vida de casi todos en el futuro cercano. Lo crucial es que las empresas no piensen que pueden habilitar estos recursos y luego desentenderse del asunto; esto no es algo que se pueda anunciar a los accionistas y poner en funcionamiento completamente en un trimestre. La educación y la capacitación serán procesos continuos, y establecer correctamente las medidas de seguridad, privacidad y cumplimiento es fundamental para aprovechar estas capacidades de manera segura y confiable.

- Inteligencia Artificial

- Seguridad de Datos

- Transformación Digital